© dpa

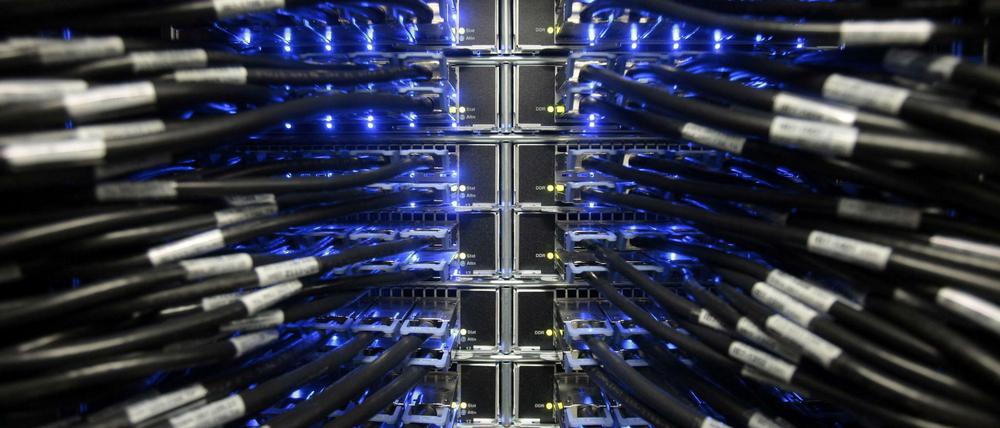

75 Jahre Computer: Millionen Milliarden mal schneller als die legendäre Z3

Die Leistung moderner Supercomputer nimmt stetig zu - und damit die Probleme für die Entwickler. Zum Beispiel die Frage: Wohin mit der Abwärme?

Von der Größe her nehmen sie sich kaum etwas. Was die Leistung betrifft, so liegen nicht nur Welten zwischen Konrad Zuses Z3 und einem modernen Supercomputer, es ist schon mehr als ein Sonnensystem. Die schrankwandgroße Maschine des Computerpioniers schaffte zwei Flops (Gleitkommaoperationen pro Sekunde). Ähnlich große Hochleistungsrechner von heute leisten einige Billionen Flops. „Tianhe-2“ (Milchstraße-2) in China füllt zwar eine Halle, bringt es aber auf den aktuellen Rekordwert von 33 Millionen Milliarden Flops (Petaflops).

Um die Relation zu verdeutlichen, hilft vielleicht dieser Vergleich: Wenn die Leistung der Z3 einem Meter entspricht, käme Tianhe-2 von hier bis zum nächsten Stern Proxima Centauri in gut vier Lichtjahren Entfernung.

Modelle der Wetterdienste werden komplexer

Ein Ende der Entwicklung ist vorerst nicht abzusehen, immer stärker werden die Maschinen – weil zugleich die Ansprüche steigen. Zum Beispiel bei den Wetterdiensten, die ohne Supercomputer nicht mehr arbeiten könnten. Sie stecken tausende aktuelle Daten zu Temperatur, Luftfeuchtigkeit und Wind in ihre Modellierungen und lassen den Computer ausrechnen, welches Wetter in den nächsten Tagen am wahrscheinlichsten ist. Um immer auf dem aktuellen Stand zu sein, werden diese Rechnungen mehrmals am Tag gestartet. Beim Deutschen Wetterdienst (DWD) dauert das je nach Modell 20 bis 80 Minuten.

„Die Aufgaben werden zunehmend komplex, dementsprechend müssen die Rechner besser werden“, sagt Philip Brown, Leiter der Abteilung Earth Sciences beim Hersteller Cray. „Wurden noch vor fünf Jahren reine Modelle zum Zustand der Atmosphäre gerechnet, kommen nun bei mittelfristigen Vorhersagen auch Modelle hinzu, die Veränderungen im Ozean berücksichtigen.“ Auch zusätzliche physikalische Eigenschaften wie zum Beispiel die Wirkung von Staubpartikeln machten die Modellierung immer aufwändiger. Der Zeitaufwand für die Rechnungen indes sollte nicht unbedingt größer werden, schließlich warten alle auf das Ergebnis.

Programme müssen mit der Rechnerarchitektur mithalten

Allein auf die berühmte Top-500-Liste zu schauen, würde dem Kunden aber nicht viel bringen, meint Brown. „Für einen groben Vergleich der Leistung mag das nützlich sein. Entscheidend ist jedoch, was auf dem System gerechnet werden soll, welche Speicherlösungen nötig sind und so weiter.“ Dementsprechend werde die Hardware angepasst – wie beim DWD, der seinen Gerätepark in den nächsten Monaten von Cray auf den neuesten Stand bringen lassen wird.

Thomas Steinke, Leiter der Arbeitsgruppe Supercomputer am Berliner Zuse-Institut (ZIB) sieht das ähnlich. „Die Programmentwickler müssen überhaupt damit umgehen können, was die Maschinen an Parallelität bieten“, sagt er. Folgerichtig ist dies eines der Forschungsthemen am ZIB: neue Programme zu entwickeln, die mit der modernen Rechnerarchitektur – beispielsweise der steigenden Anzahl von Rechenkernen auf jedem einzelnen Knoten – Schritt halten und die Möglichkeiten wirklich ausschöpfen.

Molekülsimulationen, Astrophysik, Strömung an Tragflächen

Das nützt auch den „Kunden“ des ZIB-Supercomputers. Er ist Teil des norddeutschen Rechenverbundes HLRN, Forscher der verschiedensten Disziplinen nutzen die Einrichtung: etwa für Molekülsimulationen, die bei der Entwicklung neuer Medikamente helfen, für Astrophysik oder Strömungsmodellierungen von Flugzeugtragflächen beim Landeanflug. Die Wissenschaftler profitieren von jeder Verbesserung der Computersysteme.

Wird diese dauerhaft in dem bisherigen Tempo fortschreiten? „Schwer zu sagen“, antwortet Steinke. „Derzeit arbeiten Supercomputer im Petaflop-Bereich, Anfang des nächsten Jahrzehnts dürften wir bei Exaflops ankommen. Das wären 10 hoch 18 Flops.“ Theoretisch ließe sich diese Leistung mit heutiger Technik erreichen, ergänzt er. Der Energiebedarf wäre jedoch gewaltig: rund 1000 Megawatt, so viel wie ein mittleres Kraftwerk liefert. Also müssen die vorhandenen Bauteile noch effizienter werden. Bei den Chips setzen die Hersteller weiter auf Miniaturisierung, aktuell bauen sie 14 Nanometer (Millionstel Millimeter) kleine Strukturen in ihre Halbleiter, in den nächsten Jahren wollen sie auf 7 Nanometer gehen, sagt Steinke.

Es entsteht jede Menge Wärme - und die muss weggebracht werden

Noch kleiner zu bauen, ist problematisch. Dann fließen unerwünschte Ströme und der Energieverbrauch steigt an. Ob die Forscher einmal mehr einen Ausweg finden, oder ob die Entwicklung erstmals ernsthaft stocken wird, kann heute keiner sagen.

Ein weiteres großes Problem ist die Energieeffizienz. Neben Datenbergen produzieren die Prozessoren jede Menge Wärme. Und die muss weg. „Ende der 1990er-Jahre setzte man auf starke Lüfter, um die Wärme fortzuführen und kühle Luft heranzubringen“, sagt Steinke. Doch die Wärmleitfähigkeit von Luft ist gering, und damit ihr Kühlpotenzial. Daher erlebe die Wasserkühlung, die unmittelbar an die Prozessoren heranreicht, eine Renaissance. „Manche Hersteller experimentieren mit Öl. Es ist elektrisch nicht leitend, daher versenken sie gleich die vollständigen Rechenknoten darin.“ Bei Wartung und Reparatur sei das etwas umständlich, findet der ZIB-Forscher.

Hochleistungsrechner als Heizung

In vielen Rechenzentren, die mitunter sogar eigens in kühle Gegenden wie Island gestellt werden, wird die Abwärme einfach in die Umgebung abgegeben. Das verschlechtert sowohl die wirtschaftliche wie auch die Klimabilanz. Doch es gibt auch Ansätze, diese für Heizung oder Warmwasseraufbereitung zu nutzen. So wird zum Beispiel der Neubau des Potsdam-Instituts für Klimafolgenforschung ausschließlich vom Großrechner im Keller beheizt. Soweit ist das ZIB noch nicht. Immerhin benötigt der Supercomputer dort nicht mehr eigens auf zehn Grad abgekühlte Luft, sondern kommt dank der wassergekühlten Racks auch mit „normaler“ Luft klar. Das spart ebenfalls Energie.

- showPaywall:

- false

- isSubscriber:

- false

- isPaid:

- showPaywallPiano:

- false